Google Maps "immersive View", "Multisearch Near Me" und "Scene Explorer" sind nur einige der vielen Ankündigungen, die die zunehmend visuelle Zukunft der lokalen Suche widerspiegeln.

Für alle, die die Live-Berichterstattung nicht verfolgt oder gelesen haben, hat Google auf seiner gestrigen Keynote zur Entwicklerkonferenz zahlreiche Produkte und Updates angekündigt. Zum ersten Mal bei der Google I/O ging es bei den ersten Ankündigungen vor allem um lokale Themen: Google Maps "Immersive View", "Multisearch Near Me" und "Scene Exploration". Das alles sind visuelle Suchwerkzeuge - für die reale Welt.

Google Street View trifft auf Google Earth

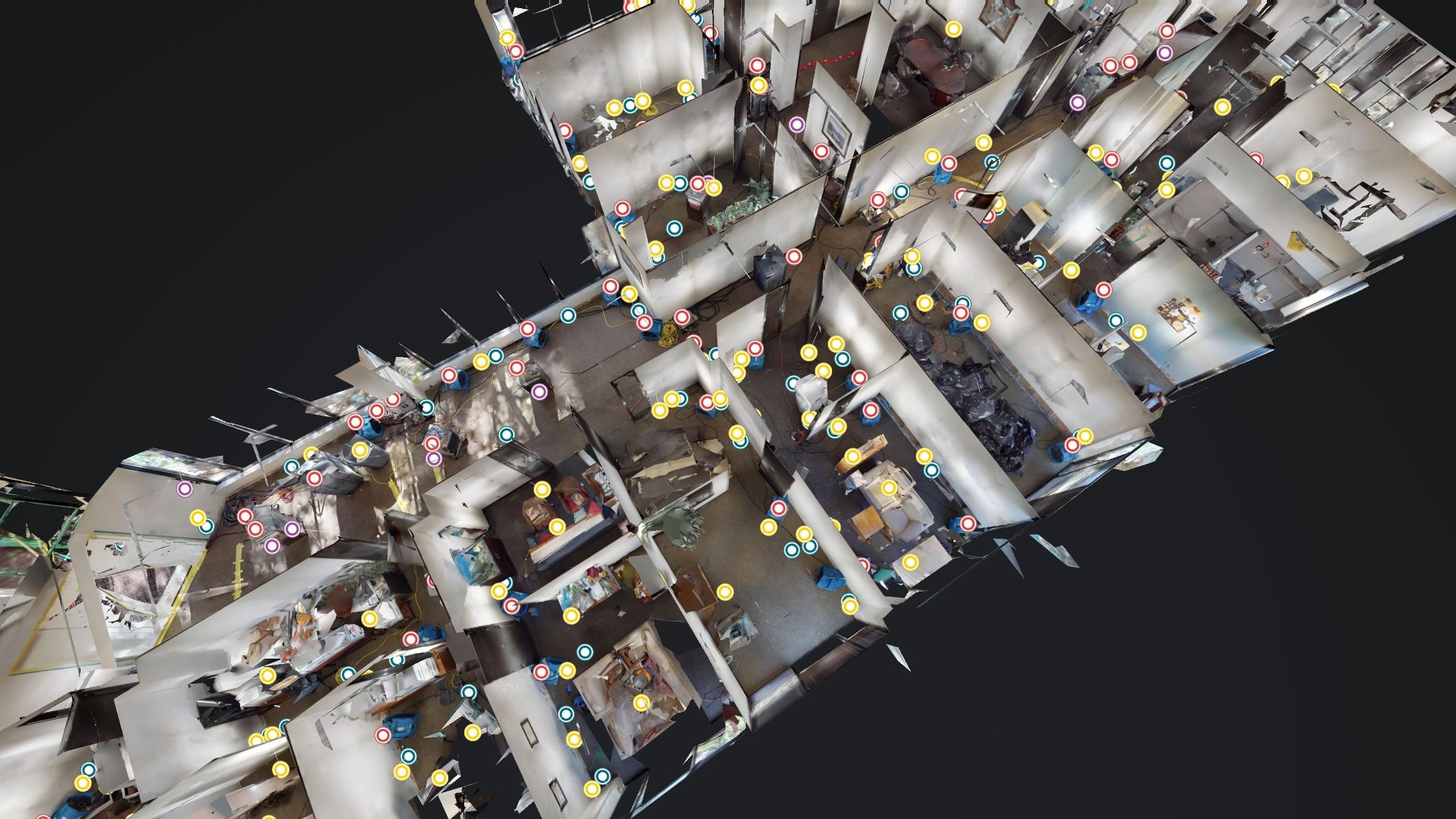

Google Maps Immersive View ist eine Kombination aus Google Street View und Google Earth, die von den maschinellen Lernfähigkeiten des Unternehmens unterstützt wird. In naher Zukunft wird es "auf jedem Smartphone" verfügbar sein und erinnert ein wenig an ein Videospiel - die Bilder sind zwar computergeneriert, aber auch sehr fotorealistisch. Immersive View wird 2022 in fünf Städten verfügbar sein: San Francisco, LA, NYC, London und Tokio. Weitere werden später hinzukommen.

In der Demo auf der Bühne hat Google Luft-, Straßen- und Innenraumbilder nahtlos miteinander verknüpft. Das Unternehmen kreiert "Video"-Touren in Innenräumen nicht durch den Einsatz von Videofilmern, sondern durch die Kombination statischer Bilder, die den Eindruck eines von einer Drohne aufgenommenen Videos erwecken. Google fügte hinzu, dass Immersive View auch "Live-Verkehr und Verkehr in der Nähe" anzeigen wird.

Google Maps ist jetzt im Wesentlichen eine Art Augmented-Reality-Anwendung, die alle lokalen Daten von Google über eine 3D-Karte der realen Welt legt, die als eine Art Metaverse-Hintergrund dienen könnte - etwas, worüber John Hanke, ehemaliger Google-Maps-Chef und jetzt CEO von Niantic Labs, vor etwa zehn Jahren mit Google Earth sprach.

Google kündigte außerdem an, dass es sein AR-Karten-Overlay Live View für Entwickler/innen öffnen wird. "Als Teil unserer Bemühungen, die Nützlichkeit von Google Maps an mehr Orte zu bringen, stellen wir Entwicklern diese Technologie jetzt mit der neuen ARCore Geospatial API kostenlos zur Verfügung. Damit können Drittanbieter AR-Erlebnisse in ihre Apps einbauen, indem sie die Street View-Bilder von Google und eine präzise Standortbestimmung nutzen.

Multisearch in meiner Nähe

Während der Keynote skizzierten die Google-Führungskräfte eine weitreichende, multimodale Vision für die Zukunft der Suche: "Suche überall und jederzeit" (Sprache, Text, Bilder, AR). In diesem Zusammenhang stellte Prabhakar Raghavan von Google "Multisearch Near Me" vor. Multisearch wurde erst vor ein paar Monaten eingeführt und bietet die Möglichkeit, die visuelle Suche von Google Lens mit Text zu ergänzen und zu verfeinern. Später in diesem Jahr wird das Unternehmen eine "Near Me"-Funktion einführen.

Für die "Multisuche in meiner Nähe" nehmen die Nutzer/innen ein Bild mit ihrer Smartphone-Kamera auf oder drücken lange auf ein Online-Bild und fügen den Text "in meiner Nähe" hinzu. Google zeigt dann an, wo das Produkt oder der Artikel in der Nähe erhältlich ist. Die beiden Beispiele, die angeboten wurden, waren Klempnerbedarf und koreanisches Essen. Google hat jedoch angedeutet, dass dies für die meisten Produkte und Kategorien funktionieren wird - aufbauend auf Googles wachsender Produktdatenbank.

Obwohl Google Lens ein erstaunliches Tool ist - Apple hat einen begrenzteren Konkurrenten, ebenso wie Pinterest und Amazon -, war es bisher eher ein Novum. Raghavan sagte jedoch, dass Google Lens "8 Milliarden Mal pro Monat" genutzt wird, eine dreifache Steigerung gegenüber dem letzten Jahr. Mit Multisearch Near Me geht Google Lens in eine sehr praktische Richtung, die, wenn sie funktioniert, die Nutzungszahlen vor allem bei der Produktsuche deutlich in die Höhe treiben dürfte.

Mehr lokale AR: Scene Explorer

Eine verwandte, experimentelle Funktion in Lens/Mulitsearch ist das, was Google "Scene Exploration" nennt. Dabei handelt es sich um ein Echtzeit-AR-Overlay für mehrere Objekte im Kamerabild. Raghavan sagte in einem Blogbeitrag, dass diese Funktion "dir helfen wird, Erkenntnisse über mehrere Objekte in einer Szene gleichzeitig zu gewinnen".

Google verwendete das Beispiel einer Reihe von Schokoriegeln in einem Ladenregal. Mit Scene Exploration können Nutzer/innen mehrere Schokoriegel vergleichen, wobei Daten über den Produktbildern eingeblendet werden: Bewertungen, Inhaltsstoffe usw. Das Unternehmen schlug vor, dass der Scene Explorer auch funktioniert, wenn du mit der Kamera herumschwenkst und die Ergebnisse aktualisiert werden, während sie sich bewegt.

Wir haben das noch nicht in Aktion gesehen. Was es tatsächlich kann und wie gut es funktioniert, bleibt abzuwarten. (Googles Live View AR-Wegbeschreibung war eine Zeit lang ziemlich lahm.) Aber je nachdem, welche Daten verfügbar sind, könnte diese Funktion sehr beliebt werden. (Ich benutze Amazon Lens regelmäßig, um Produkte nachzubestellen.)

Nebenbei bemerkt war die AR-Übersetzungsbrille von Google eine weitere beeindruckende Vorführung, über die wir ein anderes Mal sprechen werden.

Die visuelle Zukunft ist da

Diese visuellen Suchwerkzeuge und -entwicklungen basieren auf den großen Investitionen in die technologische Infrastruktur und den Fortschritten, die Google in den letzten Jahren gemacht hat, vor allem im Bereich Computer Vision.

Auch wenn diese neuen Sucherlebnisse nicht alle vom ersten Tag an gleich gut funktionieren, deuten sie auf eine sich schnell verändernde Such-UX hin: "Suche immer und überall". Die Kombination aus visuellen Informationen, AR und Daten ist für diese Vision von zentraler Bedeutung.

Wir haben kürzlich ausführlich über die visuelle Zukunft der lokalen Suche, die Bedeutung von lesbaren, qualitativ hochwertigen Bildern und die zunehmende Bedeutung von Live-Produktinventar in der Suche gesprochen. Diese Ankündigungen unterstreichen, dass Vermarkter und Unternehmer die Daten und Bilder, die sie an Google liefern, verbessern müssen, um Teil dieser zunehmend visuellen Sucherlebnisse zu sein.